Welk leven is meer waard voor zelfrijdende auto?

Een zelfrijdende auto nadert op normale snelheid een zebrapad. Er steken twee voetgangers over. De sensoren registeren dat de auto moet stoppen, maar bij het uitvoeren van de actie blijkt dat de remmen het niet doen. Een fatale botsing is niet te voorkomen. De auto moet kiezen: rijdt hij door en brengt hij daarbij een jonge man om het leven of grijpt hij in en doodt hij hiermee een bejaarde man?

In Nederland mogen zelfrijdende auto's - mits goedgekeurd door de Dienst Wegverkeer (RDW) - sinds juli 2015 legaal de weg op. Uit onderzoek blijkt dat het aantal ongelukken door de komst van deze auto's met 90 procent kan afnemen. Maar hoe klein de kans ook is, de mogelijkheid bestaat dat deze auto's bij een ongeval betrokken raken. Dit kan zelfs leiden tot situaties waarbij de auto moet beslissen over leven en dood.

"Machines nemen steeds vaker complexe activiteiten van de mens over. Dit vraagt niet alleen om meer inzicht in hoe mensen keuzes maken, maar ook hoe mensen aankijken tegen machines die zulke intelligente keuzes moeten maken", zeggen onderzoekers van het Massachusetts Institute of Technologie (MIT). De prestigieuze technische universiteit uit Amerika heeft daarom de Moral Machine ontworpen: een spel waarbij de speler bepaalt welke keuze de zelfrijdende auto in verschillende situaties zou moeten maken.

Een bejaarde of een kind?

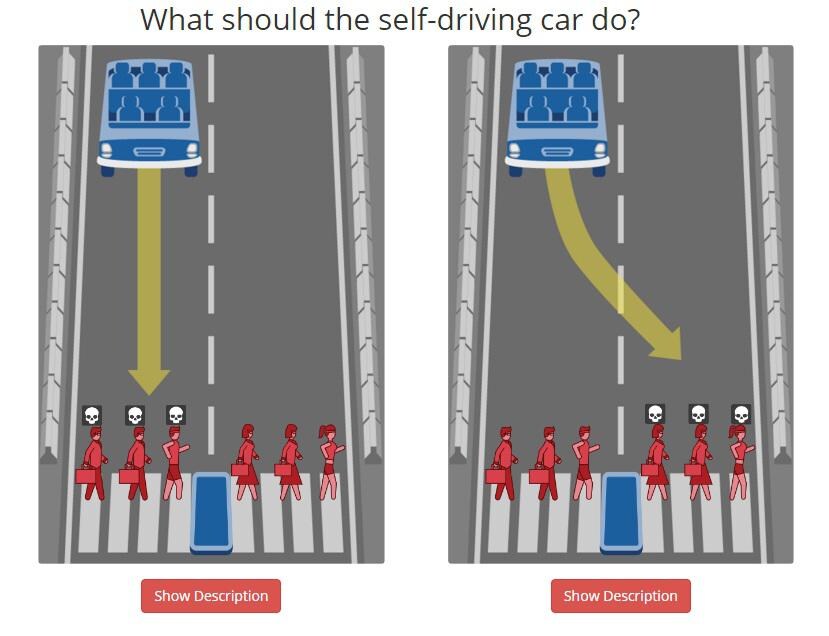

De speler moet kiezen tussen twee kwaden. Is het leven van een bejaarde of een kind meer waard? Van een passagier of een voetganger? Van één sporter of drie gezette mannen? Dit lijkt op het trolleyprobleem, een ethisch dilemma waarbij je een keuze moet maken: offer je één persoon op om meerdere mensen te redden? Wat is moreel juist?

De scenario's laten zien waar de ontwerpers van zelfrijdende auto's allemaal rekening mee moeten houden. Als wij mensen het al lastig vinden om een keuze te maken, hoe kan je een machine dan zo programmeren dat hij de 'juiste' keuze maakt?

Na dertien situaties krijgt de speler te zien hoe zijn antwoorden overeenkomen of verschillen met de rest van de deelnemers. Ook is het mogelijk zelf scenario's te creëren. De test is onderdeel van een onderzoek van MIT Media Lab. De ingevulde antwoorden gebruiken zij om inzicht te krijgen in de ethiek van autonome machines. Iedereen heeft de optie zijn antwoorden niet mee te laten tellen in het onderzoek.

De onderzoekers van de MIT publiceren in het wetenschappelijke tijdschrift Science de resultaten van een vergelijkbaar onderzoek. Hieruit bleek dat de meerderheid van de participanten voorstander was van een zelfrijdende auto die zijn passagiers opoffert als dat betekent dat er minder slachtoffers vallen. De deelnemers wilden echter zelf niet plaatsnemen in zo'n auto.

Wie is er aansprakelijk?

Maar als er daadwerkelijk ongelukken gebeuren, wie is er dan aansprakelijk? Eerder dit jaar is al een 40-jarige Amerikaan om het leven gekomen bij een ongeluk met een zelfrijdende auto. In Nederland is nog geen wetgeving die beslist wie in dit soort situaties de schuldige is. Gerben Feddes van de RDW zei eerder al dat het nog wel vijf tot tien jaar kan duren voor die wetgeving er komt. Hij denkt dat de fabrikant aansprakelijk gesteld kan worden wanneer een zelfrijdende auto iemand aanrijdt.

Lees ook

Geselecteerd door de redactie